Haber Özeti

Tam Sürüm

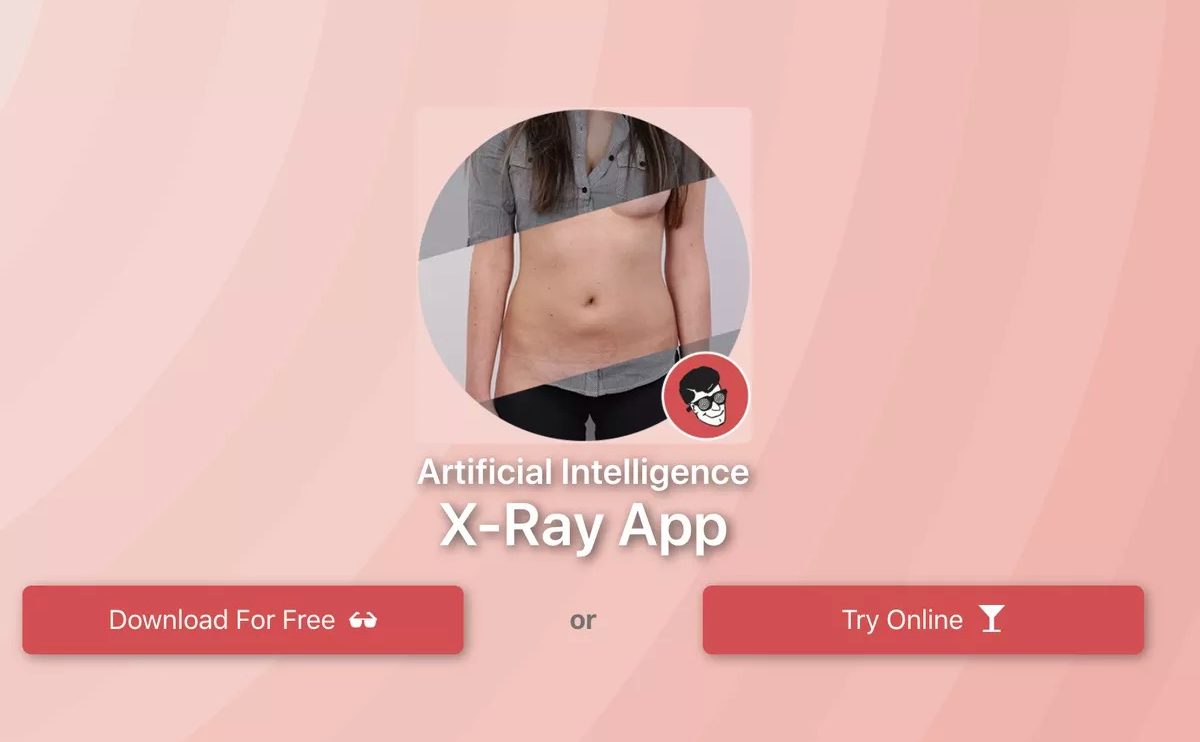

DeepNude adlı yeni bir yapay zeka uygulaması kadınların fotoğrafları üzerinde değişiklik yaparak fotoğraftaki kadını çıplakmış gibi gösterebiliyor. Windows uygulama mağazası üzerinden kullanıma sunulan uygulama, gelen tepkiler üzerine kısa sürede kaldırıldı. DeepNude ile üretilen fotoğrafların üzerinde “Deepnude.com ile üretilmiş sahte çıplak fotoğraf” ibaresi yer alıyor. Uygulamanın ücretli versiyonu kullanılarak bu yazı küçültülebiliyor. Bir fotoğraf düzenleme uygulaması ile de yazı tamamen silinebiliyor.

Bu uygulama ile üretilen fotoğraflar kadınlara şantaj yapmak ya da görüntülerin sosyal medyada yayılması ile kişilerin itibarını zedelemek için kullanılabilir. Uygulamanın geliştiricisi Alberto (tam adını paylaşmak istemiyor) bu uygulamayı eğlence amaçlı ürettiğini ve kötü niyetli kişilerin kullanması durumunda uygulamayı durdurmayı planladığını söyledi. Ancak kötü niyetli kullanımın ne olduğu ve nasıl belirleneceği konusunda bir açıklama yapmadı. Alberto, YouTube’da yarım saatlik eğitim videosu izleyen herkesin Photoshop kullanarak da fotoğraflar üzerinde böyle değişiklikler yapabileceğini söyledi ve “Bu uygulamayı bugün ben yapmasam, seneye başkası yapacaktı” dedi.

Sahte olduğunu anlamak zor değil

Uygulamada üretilen fotoğraflar incelendiğinde sahte oldukları anlaşılabiliyor. Uygulamanın daha gerçekçi sonuçlar üretebilmesi için, kullanılan orijinal fotoğraftaki kadının zaten vücudunu kısmen gösteren, mayo gibi kıyafetler giymesi gerekiyor. Uygulama erkekler üzerinde çalışmıyor. Erkek görselleri kullanıldığında DeepNude onlara da vajina eklemeye çalışıyor.

Deepfake (başkasının yüzü kullanılarak üretilen sahte görüntüler) teknolojisinin siyasi liderlerin görüntüleri kullanılarak insanların görüşlerini etkileyebileceği konuşuluyor. Ancak bu teknoloji ilk olarak, ünlü kişilerin sahte seks videolarının üretilmesi ile meşhur olmuştu. Yasalar şu anda bu konuda kararsız. Deepfake görüntüleri kişilerin itibarını zedelediği gerekçesiyle kaldırılabilir. Ancak bir kişinin kendi emeğiyle oluşturduğu videoyu yasaklamak da ifade özgürlüğüne müdahale olarak yorumlanabilir. Her halükarda, bu teknolojinin çocuklar üzerinde kullanılması durumunda suç oluşturduğunu belirtmek gerek. DeepNude uygulaması da bu gibi amaçlarla kullanılabilir.

Alberto her ne kadar böyle bir teknoloji geliştirip herkesin kullanımına sunduğu için eleştirilse de bir noktada haklı: bu teknolojiler her geçen gün yayılıyor ve DeepNude olmazsa da başka bir uygulama ile fotoğraflarınız üzerinde değişiklik yapılması mümkün. Bu yüzden internette paylaştığınız fotoğraflarınız konusunda dikkatli olmanızda fayda var.

Kaynak: The Verge

DeepNude adlı yeni bir yapay zeka uygulaması kadınların fotoğrafları üzerinde değişiklik yaparak fotoğraftaki kadını çıplakmış gibi gösterebiliyor. Windows uygulama mağazası üzerinden kullanıma sunulan uygulama, gelen tepkiler üzerine kısa sürede kaldırıldı. DeepNude ile üretilen fotoğrafların üzerinde "Deepnude.com ile üretilmiş sahte çıplak fotoğraf" ibaresi yer alıyor. Bu uygulama ile üretilen fotoğraflar kadınlara şantaj yapmak ya da görüntülerin sosyal medyada yayılması ile kişilerin itibarını zedelemek için kullanılabilir. Uygulamanın geliştiricisi Alberto (tam adını paylaşmak istemiyor) bu uygulamayı eğlence amaçlı ürettiğini söyledi.

Yorum Ekle