Haber Özeti

Tam Sürüm

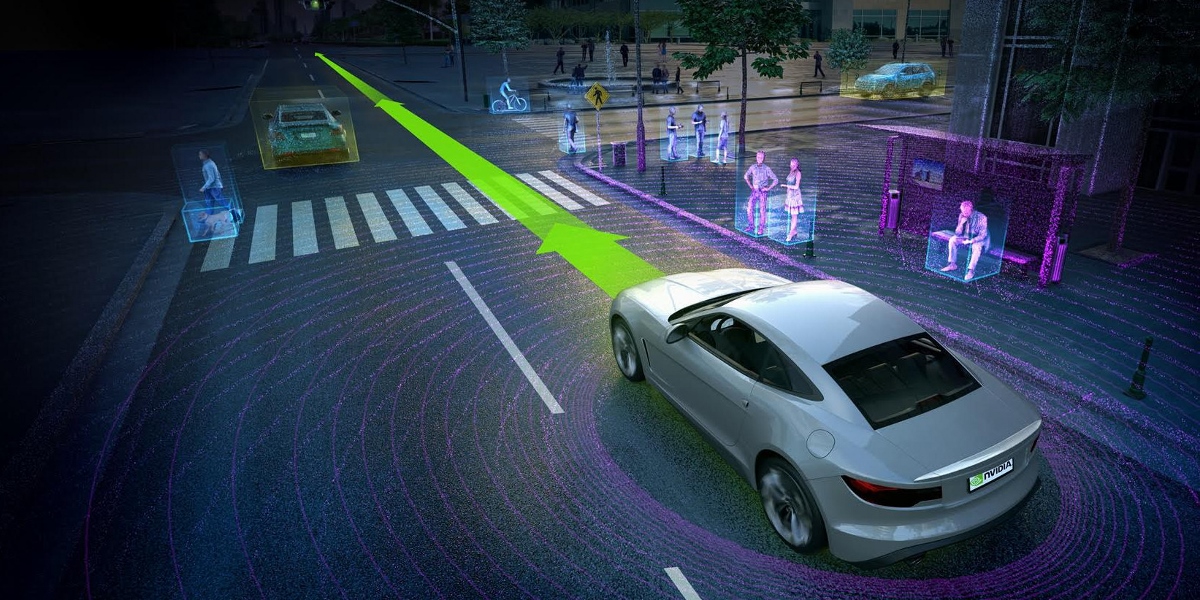

2023 yılında olduğumuzu ve sürücüsüz araçların nihayet şehirlerimizin sokaklarında gezmeye başladığını hayal edin. İlk kez bu araçlardan birisi bir yayaya çarparak ölümüne sebep oluyor ve bu olay medyada büyük yer kaplıyor. Yüksek profilli bir davanın olacağı muhtemel ama hangi yasalar uygulanmalı?

Brighton Üniversitesi’nden John Kingston‘ın henüz yasal olarak belirsiz olan bu alanda çalışmaları sayesinde bu soruya yaklaşık bir cevap verebiliriz. Kingston’ın analizleri otomotiv, bilgisayar sektörlerinin ve yasal dünyanın ciddi şekilde düşünmesi gereken bazı önemli sorunları ortaya koyuyor.

Bu tartışmanın merkezinde yapay zeka sisteminin hareketlerinden ötürü suçtan sorumlu olup olamayacağı sorusu yatıyor. Kingston, Ono Academic College’dan Gabriel Hallevy’nin bu sorunu detaylıca araştırdığını belirtiyor.

Cezai sorumluluk için genelde eylem ve niyet gerekir. Kingston, Hallevy’nin bu konuda yapay zekaya uygulanabilecek üç durumu incelediğini söylüyor.

İlki başkası aracılığıyla fail olmak. Bu zihinsel engelli kişilerin veya hayvanların işlediği ve dolayısıyla masum sayıldığı suçları kapsıyor. Ancak bu kişileri veya hayvanları bu eylemi yapmaya itenler varsa onlar bu suçtan sorumlu tutulabiliyor. Örneğin bir köpeğe başka birisine saldırması için emir veren bir kişi.

Bu, akıllı makineleri tasarlayan ve kullananlar için önem taşıyor. Kingston, böyle bir durumda kullanıcı veya yazılımcının başkası aracılığıyla fail, kullanılan yapay zeka programının ise masum sayılabileceğini belirtiyor.

İkincisi, olası doğal sonuç ile gerçekleşen suçlar. Bu yapay zekanın sıradan işlemleri sırasında suça neden olabileceği durumları belirtiyor. Kingston bununla ilgili 1981 yılında bir Japon motosiklet fabrikasında yapay zekaya sahip bir robotun insan işçinin ölümüne yol açtığı olayın örneğini veriyor:

“Robot yanlışlıkla çalışanı görevine bir tehdit olarak algıladı ve bu tehditi yok etmenin en etkili yolunun, onu bitişiğindeki makineye itmek olduğunu hesapladı. Robot çok güçlü hidrolik kollarını kullanarak şaşkın işçiyi makinenin içine iterek anında ölümüne neden oldu, sonrasında ise görevine devam etti.”

Buradaki önemli soru yazılımcının makinenin kullanımı sırasında böyle bir sonucun olası olduğunu bilip bilmemesi.

Üçüncüsü ise doğrudan sorumluluk. Bunun gerçekleşmesi için hem eylemin hem de niyetin olması gerekiyor. Yapay zekanın suça neden olacak bir eylemi gerçekleştirdiğini veya önlemek için eyleme geçmediğini kanıtlamak basit.

Kingston, niyeti saptamanın çok daha zor olsa da konuyla alakalı olabileceğini belirtiyor. “Hız yapmak bir suç. Hallevy’e göre, eğer sürücüsüz bir araba yolda hız limitini aşarsa, yasa arabayı o an kullanan cezai sorumluluğun yapay zekada olduğuna karar verebilir.” Dolayısıyla aracın sahibi sorumlu olmayabilir.

Yapay zekanın kendini savunması

Tabii bir de davalı yapay zekanın kendini savunması sorunu bulunuyor. Eğer bir yapay zeka suçtan sorumlu bulunduysa, nasıl bir savunma yapabilir? Kingston birkaç olasılığı öne sürüyor: Bozuk bir program insan gibi akıl hastalığı geçirdiğini iddia edebilir mi? Elektronik bir virüs bulaşan yapay zeka insan gibi baskı altında olduğunu veya sarhoş olduğunu iddia edebilir mi?

Bu tür savunmalar hiç de teorik değil. Kingston, Birleşik Krallık’ta bilgisayar ile alakalı suçlarla yargılanan insanların bilgisayarlarına kötü amaçlı yazılım girdiğini ve suçun asıl sorumlusunun o olduğu savunmasıyla kurtulduğunu vurguluyor.

Bir davada DOS (denial-of-service, hizmeti engelleme) saldırısı gerçekleştirmekle suçlanan genç hacker bu saldırıyı yapanın adli olarak analiz edilmeden kendini silen bir Trojan yazılımı tarafından gerçekleştirdiğini iddia etti. Kingston, davalının avukatının jüriyi böyle bir senaryonun makul şüphenin ötesinde olmadığını ikna ettiğini belirtiyor.

Son olarak bir de cezalandırma sorunu bulunuyor. Yapay zekanın doğrudan sorumlu bulunduğu bir suç için kim ya da ne cezalandırılır ve bu ceza ne biçimde verilebilir? Bu sorulara şu an için herhangi bir cevap bulunmuyor.

Ürün mü, hizmet mi?

Ancak cezai sorumluluk bu tür davalarda geçerli olmayabilir. Böyle bir durumda da davanın sivil hukuk çerçevesinde kararlaştırılması gerekecektir ve kritik soru yapay zeka sisteminin bir hizmet mi yoksa ürün mü olduğu sorusu haline dönüşecektir.

Eğer bir ürün ise, ürün tasarım mevzuatı, örneğin bir garantiye dayanarak uygulanması gerekir.

Eğer bir hizmet ise ihmalkarlık suçu geçerli olur. Bu durumda davacı ihmali kanıtlamak için üç şeyi göstermesi gerekir. Bunlardan ilki, genelde basit olan sanığın yasal bir yükümlülüğü olduğunu göstermesi. Ancak Kingston, bunu yapay zeka durumunda değerlendirmenin zor olabileceğini belirtiyor. İkincisi, sanığın bu yükümlülüğü ihlal ettiği ve üçüncü olarak bu ihlalin davalıyı yaraladığı gösterilmesi gerekiyor.

Tüm bunlar oldukça anlaşılması güç değilmişcesine, yapay zekanın kabiliyetleri insana yaklaştıkça hatta insanı aştıkça bu yasal durumlar değişebilir.

Ancak kesin olan bir şey var. O da, önümüzdeki yıllarda avukatları bu konular oldukça uğraştıracak. Ya da yerine gelen yapay zekalı avukatları…

Kaynak: MIT Technology Review

2023 yılında olduğumuzu ve sürücüsüz araçların nihayet şehirlerimizin sokaklarında gezmeye başladığını hayal edin. İlk kez bu araçlardan birisi bir yayaya çarparak ölümüne sebep oluyor ve medyada büyük bir yer alıyor. Yüksek profilli bir davanın olacağı muhtemel ama hangi yasalar uygulanmalı?

Brighton Üniversitesi'nden John Kingston'ın henüz yasal olarak belirsiz olan bu alanda çalışmaları sayesinde bu soruya yaklaşık bir cevap verebiliriz. Kingston'ın analizleri otomotiv, bilgisayar sektörlerinin ve yasal dünyanın ciddi şekilde düşünmesi gereken bazı önemli sorunları ortaya koyuyor.

Kingston, yapay zeka suça karıştığı durumlarda araştırmacı Gabriel Hallevy'e göre üç durum işleyebileceğini belirtiyor. Bunlar;

- başkası aracılığıyla fail olmak

- olası doğal sonuç ile gerçekleşen suçlar

- doğrudan sorumluluk

Yapay zeka suçlu bulunursa, Kingston yapay zekanın bozuk yazılımı ve virüs etkisiyle bu suçu işlediğini iddia edebileceğini belirtiyor. Yapay zekanın nasıl cezalandırılacağı konusu ise şu an belirsiz.

Tabii bir de yapay zeka suçlarının cezai sorumluluk çerçevesinde değil de, medeni hukuk kapsamında değerlendirilebilmesi de mümkün. Bu durumda da, önemli olan sorunun yapay zekanın bir ürün olarak mı yoksa hizmet olarak mı değerlendirilmesi gerektiğinin belirlenmesi gerekecek.

Ancak kesin olan bir şey var. O da, önümüzdeki yıllarda avukatları bu konular oldukça uğraştıracak. Ya da yerine gelen yapay zekalı avukatları...

Ceza durumları tam olarak zamanla belli olacaktır, ancak önlemler ve sorumluluklar konusunda anlık olarak kayıtların (log) tutulması ve bulut sunucuda saklanması için üreticilerin bir sistem geliştirmesi gerekir, periyodik olarak görüntülerin aktarılması, hız durumu, yazılım davranışları falan.. tabi burada da kişilerin gizlilik durumları ihlal edilebilir, o da ayrı bir hukuk problemi. Tüm bunları Amerika ve Avrupa düşünsün, Türkiye’de böyle bir şey olsa çözüm çok basit, tüm araçlar trafikten men edilir.